Hace apenas tres semanas compartimos un workshop de Prompt Engineering con un grupo de ~15 personas. La experiencia fue intensa y atractiva: exploramos fundamentos, técnicas avanzadas y casos prácticos que hoy marcan la diferencia entre un uso superficial de la IA y uno realmente transformador.

Este artículo busca capturar esa charla y convertirla en un recorrido para quienes quieran entender qué significa hoy hacer prompt engineering y cómo puede aplicarse en la práctica.

En este post quiero contarte — de manera simple, pero realista — cuál es el verdadero camino de un proyecto de Machine Learning: las claves, los desafíos y esos aprendizajes que solo se ganan haciendo. Si alguna vez te preguntaste cómo transformar una idea en resultados reales (y evitar los típicos tropiezos en el camino), este recorrido te puede ayudar!

La ingeniería de prompts es el arte (y la ciencia) de diseñar instrucciones claras y específicas para modelos de lenguaje como ChatGPT, Claude o Gemini.

Un buen prompt puede significar la diferencia entre una salida genérica y un resultado preciso, útil y alineado a los objetivos.

Durante el workshop discutimos pros y contras:

Ventajas

Desafíos

En 2026 ya no hablamos solo de “escribir preguntas mejores”.

Hoy existen técnicas específicas:

Estas técnicas muestran que el prompt engineering está en plena evolución, y cada nuevo avance expande lo que podemos lograr con simples instrucciones.

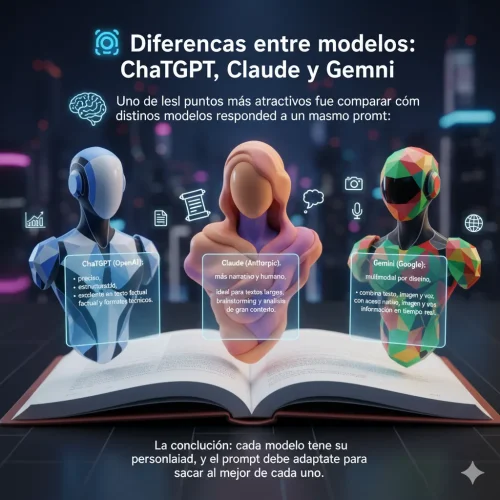

Uno de los puntos más atractivos fue comparar cómo distintos modelos responden a un mismo prompt:

Preciso, estructurado, excelente en texto factual y formatos técnicos.

Más narrativo y humano, ideal para textos largos, brainstorming y análisis de gran contexto.

Multimodal por diseño, combina texto, imagen y voz, con acceso nativo a información en tiempo real.

La conclusión: cada modelo tiene su personalidad, y el prompt debe adaptarse para sacar lo mejor de cada uno.

El salto más fuerte en este campo llegó con los nuevos modelos de este año:

En ambos casos, vimos ejemplos prácticos de cómo un buen prompt puede desencadenar resultados que antes requerían horas de trabajo manual en programación.

El workshop dejó una idea clara: el prompt engineering ya no es opcional.

En un mundo donde la IA es parte de la vida diaria de desarrolladores, analistas y creadores, saber conversar con ella de manera efectiva es tan importante como saber programar.

Y aunque los modelos seguirán mejorando y “entendiendo más con menos”, siempre habrá espacio para quienes sepan sacarles el máximo provecho con prompts bien diseñados.

En definitiva: no se trata solo de preguntar, se trata de conversar con la IA de manera estratégica.

Si estuviste en el workshop, gracias por la energía y la participación.

Y si no, espero que este artículo te acerque un poco a esa experiencia.

La conversación recién empieza.